Une étude choc de 2025 : pourquoi la répétition renforce la crédibilité des images IA

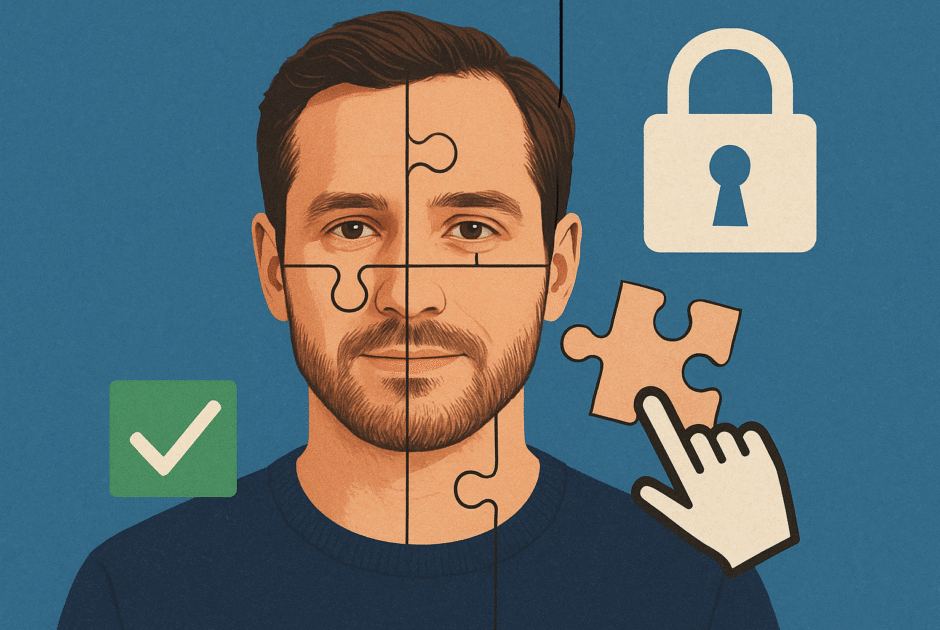

Le 30 juillet 2025, une étude retentissante publiée par Xinhua a jeté un éclairage nouveau sur la manière dont le public perçoit les images générées par intelligence artificielle. Selon les chercheurs, la probabilité qu’une personne considère une image IA comme crédible augmente de manière significative après plusieurs expositions, même si elle connaissait initialement la nature artificielle du visuel. Cet effet, connu sous le nom d' »effet de répétition », tire ses racines de la psychologie cognitive: notre cerveau, exposé à un stimulus visuel récurrent, développe un sentiment de familiarité qui se mue progressivement en authenticité perçue. Ainsi, plus une image est vue, plus elle semble conforme à la réalité.

L’impact de cet effet est démultiplié à l’ère de la généralisation d’outils comme Midjourney V6, Stable Diffusion XL ou DALL·E 3, qui permettent à des millions d’utilisateurs – professionnels et amateurs – de produire, personnaliser et diffuser des images IA au quotidien. De la publicité à l’éducation, en passant par l’actualité ou le secteur créatif, les productions actualité IA envahissent littéralement notre imaginaire collectif.

Selon la même étude, la capacité du public à distinguer le vrai du faux ne dépasse déjà plus 62%, une tendance en hausse depuis l’année précédente (Clubic). Une réalité qui alimente de nouveaux enjeux éthiques et sociétaux, alors même que la diffusion massive et répétée des images de synthèse devient quasi-incontrôlable à l’horizon 2025. Pour mieux comprendre la portée de ce phénomène, il est crucial de replacer ces résultats dans l’explosion actuelle des usages de l’actualités IA et de l’actualité intelligence artificielle.

Perceptions bouleversées : entre authenticité, manipulation et nouveaux risques

L’effet répétitif observé sur la crédibilité des images IA pose des défis immenses pour tous les acteurs de la chaîne de l’information et du actu intelligence artificielle : journalistes, communicants, spécialistes du marketing, marques et créateurs de contenu. Les premiers impacts concrets sont déjà visibles à travers plusieurs incidents marquants récents:

- En mars 2024, une vidéo deepfake du président ukrainien a circulé, semant la confusion internationale sur ses intentions réelles (IDProtect).

- En avril 2025, un faux journal de RFI utilisant des voix de journalistes clonées a été diffusé, illustrant la facilité déconcertante de manipuler l’information sonore aussi bien que visuelle (France Inter).

- En juin 2025, la guerre de désinformation entre Israël et l’Iran s’est illustrée par la multiplication de deepfakes viraux sur les réseaux sociaux, alimentant des campagnes massives de fake news (20 Minutes).

Ces dérives sont facilitées par la puissance, l’accessibilité et la versatilité croissante des plateformes comme Midjourney ou DALL·E 3, qui contribuent à une standardisation inconsciente de l’imaginaire collectif à travers des images partageant des codes ou des styles récurrents. Pour les travailleurs de la tech et des médias, il devient crucial de renforcer l’esprit critique et de mettre en place des dispositifs robustes de vérification.

Le phénomène interpelle aussi quant à la pollution numérique générée, comme analysé dans notre article sur la prolifération des contenus IA, ou sur la fragilisation croissante des frontières du vrai dans les espaces sociaux (cas de X/Twitter).

L’enjeu prime: chaque professionnel doit élaborer des stratégies défensives, mais aussi repenser sa place face à l’infiltration massive des deepfakes et autres contenus IA dans le flux de l’actualité IA.

Quelles réponses ? Garde-fous technologiques et éducation critique à l’ère des deepfakes

Face à la montée des dangers liés à la prolifération des images IA, de nombreuses initiatives émergent pour renforcer la lutte contre la désinformation et défendre l’actu intelligence artificielle éthique. Depuis juillet 2024, l’AI Act européen impose ainsi des obligations strictes de watermarking (tatouage numérique) pour les contenus générés par IA, afin d’authentifier leur origine et faciliter leur repérage. Des solutions françaises comme IMATAG ou des initiatives internationales travaillent à protéger la traçabilité des images synthétiques (lire).

Cependant, la technologie évolue rapidement: des outils tels qu’UnMarker permettent de supprimer les filigranes de façon quasi indétectable (Korben), rendant la traque des images truquées toujours plus délicate. Pour y faire face, l’écosystème se diversifie: détecteurs d’images IA avancés (Codeur.com), modèles d’authentification CNIL (CNIL), et une IA de contre-modération mise en place sur les principales plateformes de réseaux sociaux ainsi que chez les éditeurs d’outils IA.

L’avenir dépendra également d’une éducation renforcée à l’image et d’une culture de la vérification: reconnaître les codes de génération d’image IA devient un savoir de base pour naviguer l’actualités IA. Pour approfondir les innovations et limites des solutions techniques, lisez notre dossier sur les Watermark Wars ou encore l’actualité sur la détection des textes IA.

En 2025, aucune solution miracle ne prévaut: la course entre générateurs, détecteurs, et régulateurs se poursuit, soulevant la question d’une régulation agile et évolutive au service de la confiance.

Conclusion : la banalisation du faux, un défi pour toute la société

La généralisation de la confiance dans les images générées par IA, amplifiée par l’effet de répétition, bouleverse notre rapport à la vérité visuelle. À l’aube de 2026, il devient vital de repenser la notion même d’authenticité à l’ère numérique, sous peine de voir le faux s’imposer comme une référence commune. Les nouveaux garde-fous technologiques, aussi prometteurs soient-ils, peinent à suivre le rythme de l’innovation, pendant que la culture et la vigilance numérique n’ont jamais été aussi nécessaires pour garantir la fiabilité de l’actualité IA.

Cette banalisation du faux porte un risque profond de désinformation, mais aussi d’uniformisation de l’imaginaire et d’appauvrissement du débat public. Face à cette évolution, le triptyque vigilance, innovation, et culture critique s’impose pour préserver notre capacité à distinguer le vrai du synthétique dans un monde où les frontières deviennent chaque jour plus poreuses. Adopter une posture active de formation, d’expérimentation et d’échange autour de l’actu intelligence artificielle est aujourd’hui le rempart le plus solide contre la dérive du faux généralisé.